-

- 류은석 교수 이슈메이커 인터뷰, "현실보다 더 현실같은 VR"

- 2023년 8월 25일, 시사매거진 이슈메이커에 류은석 교수님이 지도하는 멀티미디어컴퓨팅시스템연구실 및 성균관대학교 실감미디어공학과 메타버스융합대학원 사업에 대한 기사가 실렸습니다. 멀티미디어컴퓨팅시스템연구실은 현실보다 더 현실같은 VR을 위해 국제공동연구를 진행중이며, 그 결과물로 제33회 과학기술우수논문상을 수상하였고, 기술개발 및 논문출판에 더불어 특허출원 및 등록까지 진행하고 있습니다. 이에 더불어 성균관대학교 내 실감미디어공학과를 신설, 과학기술정보통신부의 인재양성사업인 '메타버스 융합대학원' 사업에 선정되어 테크와 콘텐츠를 모두 아우르는 실감형 메타버스 기술을 선도하는 전문가 양성을 적극적으로 진행중입니다. 기사 원문

-

- 작성일 2023-08-28

- 조회수 564

-

- DSAIL.(지도교수: 한진영), KDD2023 논문 채택

- DSAIL.(지도교수: 한진영)의 이다은(인공지능융합학과), 손세정(인공지능융합학과), 전효림(인공지능융합학과) 학생들이 연구한 논문 “Towards Suicide Prevention from Bipolar Disorder with Temporal Symptom-Aware Multitask Learning” 이 세계 최고 권위 데이터마이닝 학회인 KDD 2023 (The 29th ACM SIGKDD Conference on Knowledge Discovery and Data Mining), Applied Data Track Full papers에 채택되었습니다. 논문은 23년 8월 미국 캘리포니아 롱비치에서 발표했습니다. 본 논문은 인공지능융합학과 박사과정 및 석사과정 학생들의 협업을 통한 결과물로서 소셜 미디어 상에서 나타나는 조울증 환자들의 미래 자살 경향성을 예측하기 위해, 새로운 데이터셋과 Temporal Symptom-Aware Attention 기법을 적용한 Multitask Learning 모델을 제안하였습니다. 논문의 자세한 내용은 다음과 같습니다. [논문] Daeun Lee, Sejung Son, Hyolim Jeon, Seungbae Kim and Jinyoung Han, “Towards Suicide Prevention from Bipolar Disorder with Temporal Symptom-Aware Multitask Learning,” In Proceedings of the 29th ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2023), Aug. 2023. [Abstract]. Bipolar disorder (BD) is closely associated with an increased risk of suicide. However, while the prior work has revealed valuable insight into understanding the behavior of BD patients on social media, little attention has been paid to developing a model that can predict the future suicidality of a BD patient. Therefore, this study proposes a multi-task learning model for predicting the future suicidality of BD patients by jointly learning current symptoms. We build a novel BD dataset clinically validated by psychiatrists, including 14 years of posts on bipolar-related subreddits written by 818 BD patients, along with the annotations of future suicidality and BD symptoms. We also suggest a temporal symptom-aware attention mechanism to determine which symptoms are the most influential for predicting future suicidality over time through a sequence of BD posts. Our experiments demonstrate that the proposed model outperforms the state-of-the-art models in both BD symptom identification and future suicidality prediction tasks. In addition, the proposed temporal symptom-aware attention provides interpretable attention weights, helping clinicians to apprehend BD patients more comprehensively and to provide timely intervention by tracking mental state progression.

-

- 작성일 2023-08-16

- 조회수 466

-

- DSAIL Lab (지도교수: 한진영), CIKM Short paper 채택

- DSAIL Lab (지도교수: 한진영)의 정주호(인공지능융합학과), 강채원(인공지능융합학과), 윤지우(인공지능융합학과) 학생들이 연구한 논문 “SAFE: Sequential Attentive Face Embedding with Contrastive Learning for Deepfake Video Detection”이 세계 최고 권위 정보검색(Information Retrieval) 및 데이터마이닝 학회인 CIKM 2023 (32nd ACM International Conference on Information and Knowledge Management), Short papers에 채택되었습니다. 논문은 23년 10월 영국 버밍엄에서 발표될 예정입니다. 본 논문은 효과적인 딥페이크 비디오 탐지를 위해 딥페이크 비디오 영상 속에서 얼굴의 동적인 특징을 잡아낼 수 있는 SAFE (Sequential Attentive Face Embedding) 모델을 제안하였습니다. 이전의 연구들과 달리, 이 모델은 얼굴에서 나타나는 지역 정보(Local dynamics)와 전체 정보(global dynamics) 모두를 고려하여 비디오 영상의 진위여부를 파악하고, 나아가 contrastive learning을 통해 학습 과정을 최적화하였습니다. 논문의 자세한 내용은 다음과 같습니다. [논문] Juho Jung, Chaewon Kang, Jeewoo Yoon, Simon S. Woo, Jinyoung Han, “SAFE: Sequential Attentive Face Embedding with Contrastive Learning for Deepfake Video Detection,” In Proceedings of the 32nd ACM International Conference on Information and Knowledge Management (CIKM 2023), Oct. 2023. [Abstract]. The emergence of hyper-realistic deepfake videos has raised significant concerns regarding their potential misuse. However, prior research on deepfake detection has primarily focused on image based approaches, with little emphasis on video-based detection. With the advancement of generation techniques enabling intricate and dynamic manipulation of entire faces as well as specific facial components in a video sequence, capturing dynamic changes in both global and local facial features is crucial in detecting deepfake videos. This paper proposes a novel sequential attentive face embedding, SAFE, that can capture facial dynamics in a deepfake video. The proposed SAFE can effectively integrate global and local dynamics of facial features revealed in a video sequence using contrastive learning. Through a comprehensive comparison with the state-of-the-art methods on the DFDC (Deepfake Detection Challenge) dataset and the FaceForensic++ benchmark, we show that our model achieves the highest accuracy in detecting deepfake videos on both datasets.

-

- 작성일 2023-08-14

- 조회수 388

-

- 김재광 교수 연구실, CIKM Short paper 채택

- main Lab.(지도교수: 김재광)의 고동근(인공지능융합학과), 이동준(전자전기컴퓨터공학과), 박남준(소프트웨어학과), 노경래(소프트웨어학과), 박현진(소프트웨어학과) 학생들이 연구한 논문 “AmpliBias: Mitigating Dataset Bias through Bias Amplification in Few-shot Learning for Generative Models” 이 세계 최고 권위 정보검색(Information Retrieval) 및 데이터마이닝 학회인 CIKM 2023 (32nd ACM International Conference on Information and Knowledge Management), Short papers에 채택되었습니다. 논문은 23년 10월 영국 버밍엄에서 발표될 예정입니다. 본 논문은 인공지능융합학과와 전자전기컴퓨터공학과 및 소프트웨어학과 석사과정 학생들과 소프트웨어학과 2학년 학부생의 협업을 통한 결과물로서 데이터셋에 존재하는 bias sample로 인한 인공지능 모델의 부정확함을 줄이기 위해 생성모델을 통한 Few shot learning을 하여 Debiased 모델학습 방법을 제안하였습니다. 논문의 자세한 내용은 다음과 같습니다. [논문] Donggeun Ko, Dongjun Lee, Namjun Park, Kyoungrae Noh, Hyeonjin Park and Jaekwang Kim, “AmpliBias: Mitigating Dataset Bias through Bias Amplification in Few-shot Learning for Generative Models,” In Proceedings of the 32nd ACM International Conference on Information and Knowledge Management (CIKM 2023), Oct. 2023. [Abstract]. Deep learning models have demonstrated successful performance in image classification tasks. However, these models exhibit a dependency on peripheral attributes of input data, such as shapes and colors, eventually leading to become biased towards these certain attributes, resulting in subsequent degradation of performance. To address this issue, debiasing techniques have been explored to enhance the robustness of model from biases. Recent debiasing techniques improve biased classifier f_b by reweighting technique or augment the biased dataset to mitigate bias. In this paper, we focus on the latter approach, presenting AmpliBias, a novel framework that tackles dataset bias by leveraging generative models to amplify bias and facilitate the learning of debiased representations of the classifier. Our method involves three major steps. First, we train a biased classifier, f_b, using a biased dataset and extract top-K biased-conflict samples. Subsequently, we train a generator on a bias-conflict dataset composed solely of the top-K samples to learn the distribution of bias-conflict samples. Finally, we re-train the classifier with the new debiased dataset, allowing the biased classifier to competently learn debiased representation. Extensive experiments validate that our proposed method effectively debiases the biased classifier.

-

- 작성일 2023-08-11

- 조회수 408

-

- 오하영 교수 연구실, CIKM2023 컨퍼런스 논문 Accept

- 오하영 교수연구실 LAMDA Lab에서 김미래, 황규범 학생이 발표한 Can a chatbot be useful in childhood cancer survivorship? Development of a chatbot for survivors of childhood cancer 논문이 CIKM (ACM International Conference on Information and Knowledge Management)의 Poster 세션에 Accept 되었다. 논문의 내용은 소아암 생존자를 위한 정보 전달 및 공감형 챗봇 개발에 관한 연구로 소아암 생존자 관련 데이터 구축 및 도메인 학습 기법을 활용하여 소아암 생존자의 특성을 고려한 챗봇 개발을 소개한다. CIKM (ACM International Conference on Information and Knowledge Management)는 1992년 첫 개체되어 올해로 32회를 맞은 데이터베이스, 정보검색(Information retrieval), 지식관리(Knowledge management) 분야의 권위 있는 학회로 오는 10월 21일부터 10월 25일까지 영국에서 개최된다. CIKM 2023(https://uobevents.eventsair.com/cikm2023/)

-

- 작성일 2023-08-08

- 조회수 935

-

- Georgios N. Yannakakis 교수님 초청 특강(AI and Games: The Virtuous Cycle)

- 2023년 7월 20일 국제관 90104 강의실에서 University of Malta의 교수이자 modl.ai의 공동창업자인 Georgios N. Yannakis 교수님의 강연이 있었습니다. 주제명은 "AI and Games: The Virtuous Cycle" 이었으며, 게임을 통한 AI기술의 발전과 게임 내 인간의 상호작용 패턴을 분석하고 더 나은 게이밍 경험을 제공하기 위한 인공지능의 활용에 대한 내용이었습니다. 실감미디어공학과 교수진 및 연구원들은 강연에 참가하여 발전하는 디지털 게임 및 AI의 상호작용에 대한 식견을 넓혔습니다. 강연 이후 활발한 질의응답을 통해 서로의 연구를 공유하며 연구 접목 방향에 대해 생각해 볼 수 있는 뜻깊은 시간을 가졌습니다.

-

- 작성일 2023-07-21

- 조회수 512

-

- [교수동정] 류은석 교수, 제33회 과학기술우수논문상 수상

- 본교 실감미디어공학과 류은석 교수는 2023년 7월 6일 한국과학기술단체총연합회 주관 제33회 과학기술우수논문상을 수상하였다. 류은석 교수는 한국방송·미디어공학회 대표로 수상하였고, 방송공학회논문지 제27권 제6호에 게재된 '대형 가상현실 공연장을 위한 360도 비디오 스트리밍 시스템' 이라는 제목의 논문으로 수상하였다. 과학기술우수논문상은 한국과학기술단체총연합회에서 수여하는 국내 과학기술계 최고 권위의 학술상 중 하나로, 1991년부터 수여된 바 있다.

-

- 작성일 2023-07-12

- 조회수 542

-

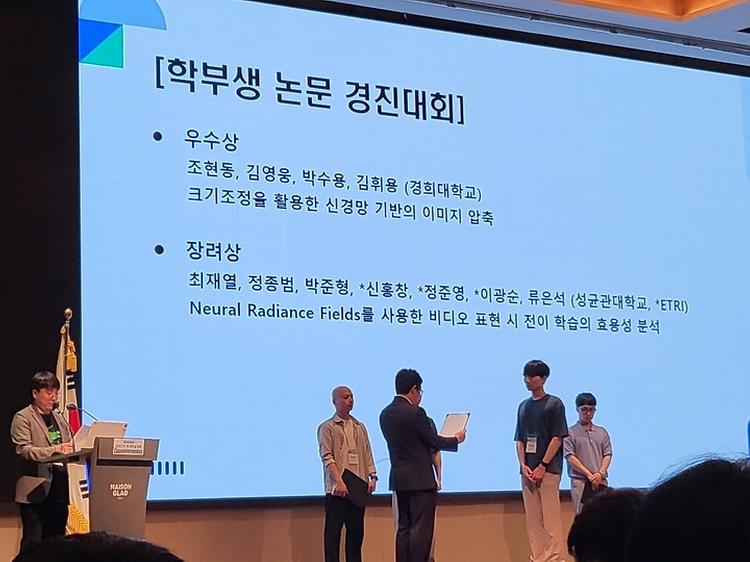

- [일반] 2023년 한국 방송미디어공학회 하계학술대회 장려상 수상

- Multimedia Computing System Lab. (MCSLab, 지도교수 류은석) 소속 류영일, 정종범, 최이현, 최재열, 박준형, 양이삭 학생이 2023년 6월 28일부터 30일까지 제주 메종글래드 호텔에서 진행된 2023 한국 방송미디어공학회 하계학술대회에 참가하였습니다. 이번 학술대회에서 MCSL 연구원들은 타 기관 연구원들의 발표를 들으며 발전하는 미디어 및 딥러닝 기술에 대한 식견을 넓혔으며, 아래와 같이 몰입형 비디오 취득, 동적 매쉬 표준(Dynamic Mesh), 신경망 기반 복사 필드(Neural Radiance Fields) 관련 주제로 한 논문을 구두발표를 하였습니다. 학생들이 발표한 논문 중 최재열 학생은 학부생 논문 경진대회에서 장려상을 수상하였습니다. ETRI(한국전자통신연구원)과 공동 연구를 진행하였으며, 딥러닝을 활용한 3차원 동적 공간 재구성시 프레임간 파라미터 공유 및 fine-tuning을 실시하는 실험을 진행하고 결과에 대해 분석한 논문입니다.

-

- 작성일 2023-07-03

- 조회수 560

-

- [일반] 류은석 교수 연구실, ACM NOSSDAV 2023 논문 발표

- Multimedia Computing Systems Lab. (MCSLab, 지도교수 류은석) 이순빈 학생의 논문 "Implementing Partial Atlas Selector for Viewport-dependent MPEG Immersive Video Streaming"이 영상처리분야 우수학술대회인 (BK21 및 정보과학회 인정) ACM Workshop on Network and Operating System Support for Digital Audio and Video 2023 (ACM NOSSDAV 2023) 에 게재 승인되어 정종범 학생이 참여하여 발표를 진행하였으며 몰입형 메타버스 영상 스트리밍 기법에 대한 심도있는 질의응답을 진행하였습니다. NOSSDAV 2023은 멀티미디어 시스템 분야의 Flagship Conference인 ACM Multimedia Systems 2023 (MMSys'23) 의 Workshop으로, 2023년 6월 10일에 개최되었습니다. 학회 중 TNO의 Simon Gunkel 연구원, video-based point cloud coding (V-PCC) 연구를 진행중인 싱가포르 국립대학교의 Wei Tsang Ooi 교수님, video decoding interfaces (VDI) 관련 연구를 진행중인 샤오미의 Emmanouil Potetsianakis 연구원 및 영상 관련 연구를 진행하는 연구원들과 여러 세션에서 교류를 할 수 있었던 뜻 깊은 시간이었습니다. 논문 Link: https://dl.acm.org/doi/10.1145/3592473.3592570

-

- 작성일 2023-06-14

- 조회수 716

-

- [일반] Purdue대학 민병철 교수님 초청 세미나 실시

- 2023년 6월 7일(수) 미국 Purdue 대학교 Smart Machine and Assistive Robotics Technology(SMART) Lab의 Byung-Cheol Min 교수님께서 성균관대학교에 방문하셨으며 세미나를 진행하였습니다. 해당 세미나는 Integrating Human Intelligence into Robot Learning에 관한 주제로 진행되었으며 SMART Lab에서 연구중인 로보틱스 기술에 대한 내용을 다뤘습니다. 멀티미디어컴퓨팅시스템연구실(지도교수 류은석)에서는 정종범, 류영일, 최이현, 최재열, 박준형 연구원이 참석하였으며 성균관대학교의 김장현 교수님, 김재광 교수님, 오하영 교수님, 민무홍 교수님, 이장원 교수님, 인하대학교의 홍성은 교수님께서 참석해주셨습니다. 그 외에도 성균관대학교 학생들이 참석하여 SMART Lab에서 연구하는 로보틱스 기술에 대해서 들을 수 있는 유익한 시간이었습니다.

-

- 작성일 2023-06-08

- 조회수 654

발전기금

발전기금