-

-

-

-

- 2023 실감미디어공학과 대학원 개원식 및 현판식 성료

- 소프트웨어융합대학은 지난 9월20일(수) 실감미디어공학과 대학원 개원식을 인문사회과학캠퍼스 호암관에서 성황리에 개최하였다. 개원식에는 이은석 소프트웨어융합대학장을 비롯하여 김장현 글로벌융합학부장, 류은석 실감미디어공학과장 및 학과 소속 교원 및 실감미디어공학과 대학원 신입학생들이 참석하여 실감미디어공학과의 첫 발걸음을 힘차게 응원하였다. 이은석 학장은 축사에서 "첨단분야로 신설된 소프트웨어융합대학 실감미디어공학과가 혁신적인 연구, 국내외 교육 및 산업체와의 지속적인 협력을 통하여 전문적이고 적극적인 글로벌인재양성에 앞장설 수 있을 것"이라고 격려했다. 개원식 본 행사에서는 LG전자, 삼성전자, SK텔레콤, 그리고 KBS, ETRI 등 국내외 산업체 및 방송사와 연구/포럼단체의 개원 축하 메시지가 소개되어 산업계 및 관련분야의 본 학과에 대한 관심도를 확인할 수 있는 자리가 되었다. 이후 다산경제관 32103A호에 위치한 실감미디어공학과 오픈랩으로 이동하여, 메타버스융합대학원(실감미디어공학과 대학원) 현판식으로 이어졌다. 해당 공간은 실감미디어공학과 대학원생들이 자유롭게 학습, 연구하고 소통할 수 있는 열린 공간으로 활용될 예정이다. 실감미디어공학과는 지난 5월 과학기술정보통신부의 인재양성사업인 '메타버스 융합대학원 지원사업' 선정으로 설립된 첨단분야 신설학과로서 메타버스 전 분야 글로벌 표준을 선도하는 전문인력 및 콘텐츠 기획/제작/프로모션/출시 등을 포괄하는 메타버스 산업전문인력을 양성할 목적으로 설립되었다. 2023년에 5억원, 이후 연간 10억원씩 총 6년(4+2년, 단계평가)간 55억원 규모의 사업비를 지원받고 매년 20명 이상의 석,박사 과정 대학원생을 신규로 받아 교육할 계획이다.

-

- 작성일 2023-09-22

- 조회수 934

-

-

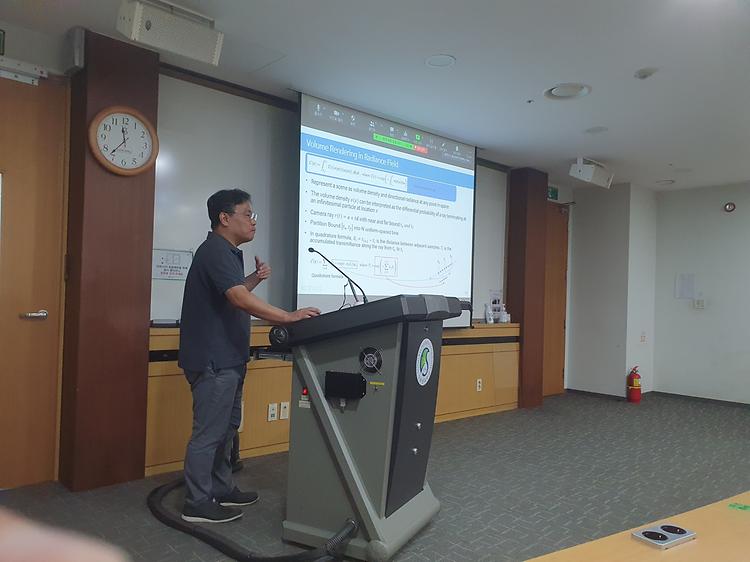

- [일반] 실감미디어공학과 세미나 3주차 문경식 박사 특강 성료

- 안녕하세요, 실감미디어공학과 사무실입니다. 9/14, 실감미디어공학과 세미나 3주차가 국제관 9B312에서 성료되었습니다. Meta에서 근무하시는 문경식 박사님께서 (Postdoctoral Research Scientist of Reality Labs Research at Meta) Understanding Humans in the 3D Space 이라는 주제로 강연을 해주셨습니다. 산업에서 사용되는 다양한 연구와 사례를 접하며 견문을 넓힐 수 있는 시간이었습니다.

-

- 작성일 2023-09-19

- 조회수 464

-

- 2023 메타버스융합대학원 현판증정식

- <왼쪽부터 류은석 성균관대학교 교수, 김형석 건국대학교 교수, 유지범 성균관대학교 총장, 전영재 건국대학교 총장, 이종호 과학기술정보통신부 장관, 전성배 정보통신기획평가원장, 배덕효 세종대학교 총장, 송형규 세종대학교 교수> 과학기술정보통신부는 13일 건국대학교에서 ‘2023년 메타버스 융합대학원 통합 현판 증정식 및 총장 간담회’를 진행하였다. 이번 현판 증정식은 2023년에 ‘메타버스 융합대학원 사업’에 선정된 성균관대, 건국대, 세종대를 축하하는 자리다. 지난해 선정된 서강대 및 한국과학기술원(KAIST)을 포함해 5개 대학의 총장과 연구책임자 등이 성공적인 대학원 운영 방향과 대학원 간 교류 및 협력 활성화 방안이 논의됐다. 메타버스 융합대학원은 메타버스 특화 연구 및 교육과정 개발 및 운영, 산업 현장 현안 해결을 위한 협력 기업과의 산학협력 과제 등을 수행한다. 이를 통해 메타버스 서비스 기획‧연구개발‧사업화 등 전 단계를 아우르는 핵심 능력을 갖춘 최고급 융합형 인재를 양성하는 것을 목표로 한다. <사진 출처 : 연합뉴스>

-

- 작성일 2023-09-14

- 조회수 522

-

- "경영대학 수석 졸업 서수연 학생, 본교 실감미디어공학과 석박통합과정 진학"

- 2023년도 여름, 우리학교 경영대학 수석 졸업생인 서수연 학생이 조기졸업과 동시에 실감미디어공학과(석박통합과정)로 진학했다. 서수연 학생은 2020년도에 우리학교 경영대학 글로벌경영학과로 입학 후 Dean's List 에 5회 이상, 국가우수장학생(인문100년)으로 선정되는 등 뛰어난 학업 성적을 보였으며 방학 중에는 덴마크 교환학생과 스타트업에서의 인턴 과정을 수료 했다. 3학년부터 학부연구생으로 여러 국책 과제들의 영문 번역 및 연구 과정에 참여했고, 일본에서 열린 국제학술대회에서는 생성형AI와 관련된 주제로 발표한 바 있다. 서수연 학생은 소프트웨어연구실(지도교수 민무홍)에서 생성형AI 및 실감미디어컨텐츠에 관한 연구를 진행 할 예정이다.

-

- 작성일 2023-09-11

- 조회수 1209

-

- 실감미디어공학과 세미나 2주차 스위스대사관 공동주최 "SWISS XR Week:Converging Metaverses & AI in the Media Space" 성료

- 본교 실감미디어공학과(학과장: 류은석 교수)와 스위스대사관이 공동 주최한 SWISS XR Week:Converging Metaverses & AI in the Media Space 워크샵이 9/5(화) 인문사회과학캠퍼스 국제관에서 지능형멀티미디어연구센터의 도움으로 성료하였다. 본 워크샵은 대한민국과 스위스의 수교 60주년을 기념하여 이루어진 양국간 기술교류 행사 중 하나로 XR(eXtended Reality)기술과 관련하여 성균관대학교 SW융합대학 실감미디어공학과와 스위스 연구기관과의 교류협력을 위해 마련되었다. 스위스 측에서는 EPFL 및 ETH 등에서 14명의 전문가가 내한하였고 본교 교수 및 대학원생들이 온·오프라인으로 참여하였다. 세미나는 크게 연구 및 미디어아트, 혁신과 기술이전, 업계사례로 나뉘어 다음와 같이 진행되었다. o Eun-Seok Ryu (Sungkyunkwan University) –MPEG Immersive Video Standard and Data Acquisition o Hyun Ju Kim (Seoul Media Institute of Technolog) – Introducing MIVA: A Media Art Practice in Korea using Metaverse & Digital Human o Jason Kim (Salin) – Promoting Inclusive Cultural Experience through XR o Yun Geuk Kang (Sejong University) – Innovative Changes in Media Production Environment o Mounir Krichane (Swiss Federal Institute of Technology Lausanne) –IMI: Connecting Academia and Media to Drive Innovation 본 워크샵은 미래 멀티미디어 XR기술을 공동주제로 양국간의 대학과 기업, 연구단체의 기술적, 산업적 진행사항을 상호 공유하는 좋은 기회였다, 특히 류은석 학과장은 올해 수주한 메타버스융합대학원 인재양성사업과 관련된 양국간 상호협력을 위해 스위스 ETH 및 EPFL의 미디어연구소와 본교 실감미디어공학과간 기술교류 및 학생파견에 대한 미래 협력을 논의하였다.

-

- 작성일 2023-09-06

- 조회수 534

-

발전기금

발전기금